Siamese Natural Language Tracker: Tracking by Natural Language Descriptions with Siamese Trackers

Introduction

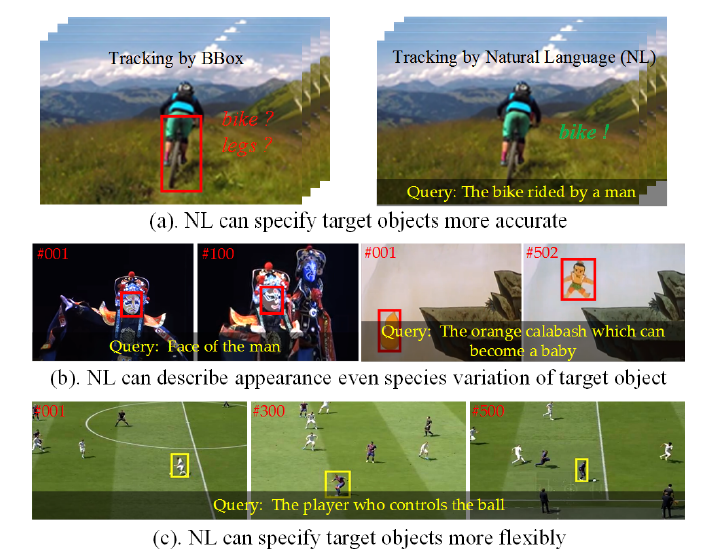

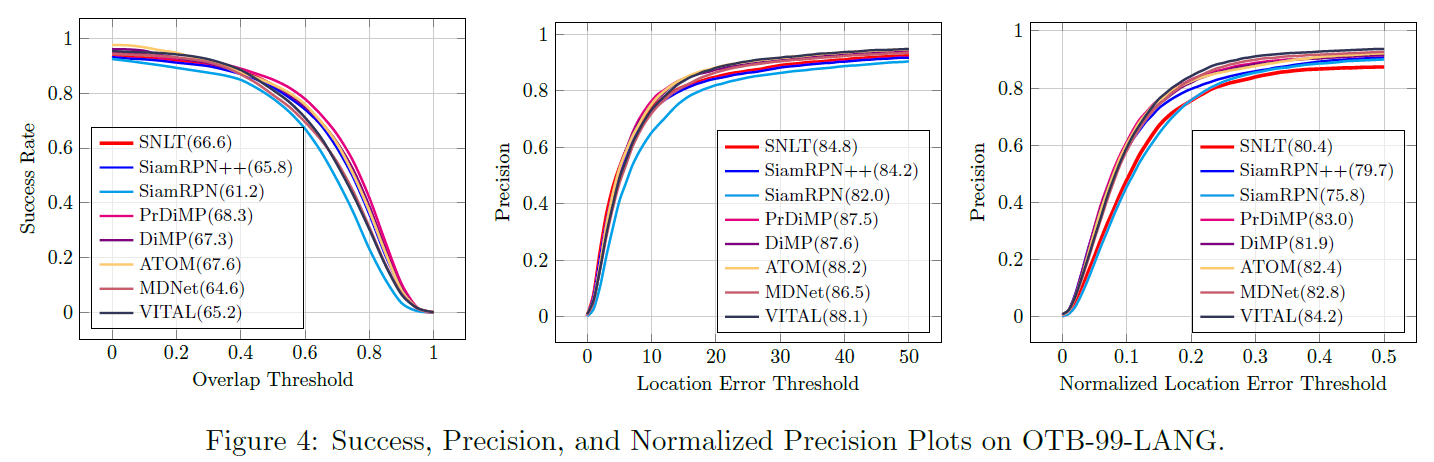

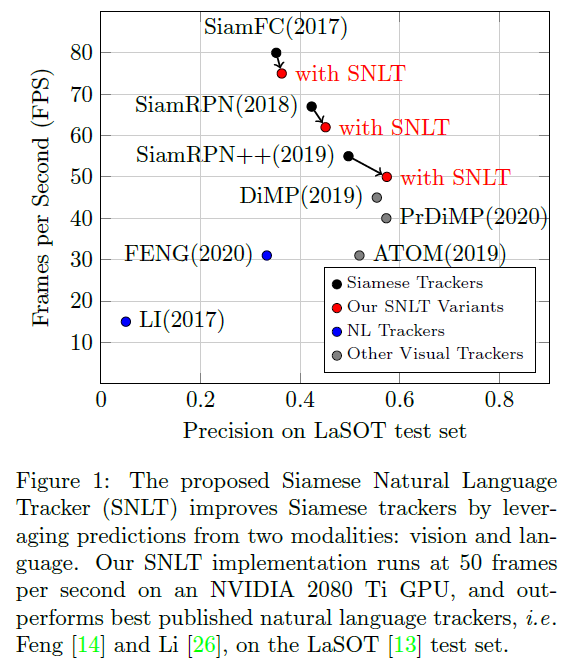

本文研究的课题为tracking by natural language(NL) 。人类的学习过程是视觉和语言共同作用的,而在基于外观的跟踪过程中引入语言描述同样可以使得跟踪器更加精确、灵活和鲁棒(如图1的例子)。因此,本文将孪生跟踪器与语言描述结合,将语言描述编码成一个卷积核嵌入到孪生框架中(SNL-RPN),并将视觉和语言的预测进行动态聚合(Dynamic Aggregation),为tracking by NL任务提供了一个新的baseline。具体贡献总结如下:

- 提出一种新的tracking by NL的baseline,Siamese Natural Language Region Proposal Network (SNL-RPN);

- 提出了一种基于视觉和语言预测的动态聚合(Dynamic Aggregation),将SNL-RPN转换为Siamese Natural Language Tracker (SNLT);

- 在NL标注的数据集上将孪生跟踪器的性能提升了3-7个百分点,并且性能超过其他NL tracker,速度为50FPS。

Method

Overview

上图展示了SNLT整体框架,将语言描述嵌入到SiamRPN++中。输入包含三部分:模板、搜索区域和查询语言Q。模板和搜索区域经过卷积提取特征$Z$和$X$,查询语言经过语言模型(BERT, GloVe, HGLMM)提取句子嵌入编码$Z_Q$。三元组$(Z,Z_Q,X)$送入SNL-RPN,分别预测视觉和语言的分类和回归响应。最后二者通过Dynamic Aggregation Module进行融合。

Architecture of the SNL-RPN

SNL-RPN如上图b所示,包括蓝色部分的visual head和红色部分的NL head,都是通过DW-XCorr生成相应的的分类和回归响应。类似SiamRPN++,同样在ResNet的三个stage上进行预测,并将结果融合,融合权重通过离线训练得到。visual head和NL head各包含两个分支,总共有四组融合参数:

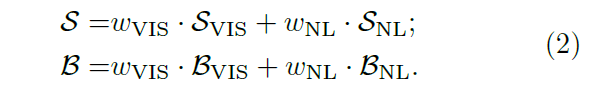

$S_{VIS}, S_{NL}$表示分类分支的视觉和语言预测,$B_{VIS},B_{NL}$表示回归分支的两种预测。

Aggregation of the SNL-RPN Predictions

上一节对不同stage的预测融合,本节作者对视觉和语言的结果再次进行融合:

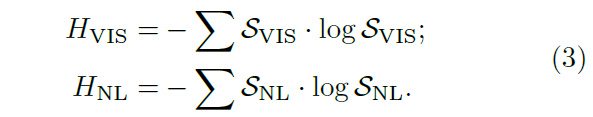

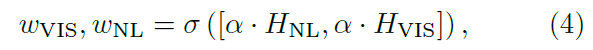

$\omega_{VIS},\omega_{NL}$ 可以简单像上面一样离线训练得到,但是融合对象来自两个不同的输入,用固定的权重融合并不是最优的。因此,作者提出一个基于预测响应图熵的动态融合方式:

其中$\sigma$表示softmax函数,$\alpha$表示缩放因子。公式4的含义是熵越大的项赋予更小的权重。熵越大表示预测图分布越混乱,越不准确,所以权重更小。

Training the SNL-RPN and Loss Functions

训练设置和siamese框架一样,额外增加了一个语言模型。损失函数分别计算视觉和语言对应的分类回归损失。

Experiments

训练数据集使用的是 MSCOCO, YouTube-BB, VisualGenome, LaSOT, OTB-99-LANG,其中后三个都是有语言标注的,前两个只有类别标注。

测试数据集使用有语言标注的OTB-99-LANG和LaSOT。

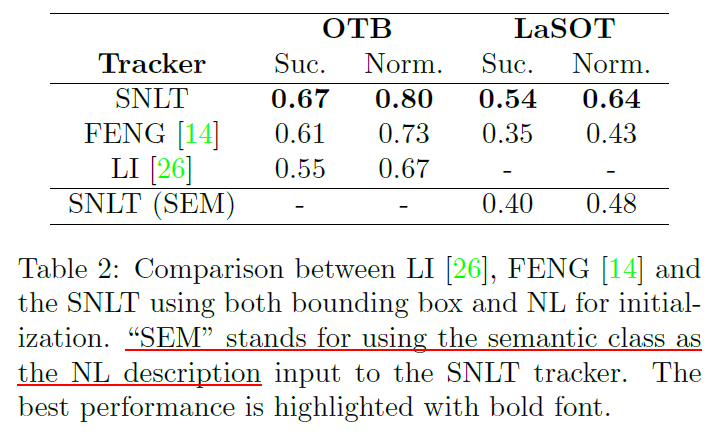

Comparison with Visual and NL Trackers

表2最后一行表示只使用语义类别作为语言输入测试LaSOT(原始的LaSOT里语言描述是一句话),这样效果会下降,证明SNLT可以学到比语义类别更多的东西。

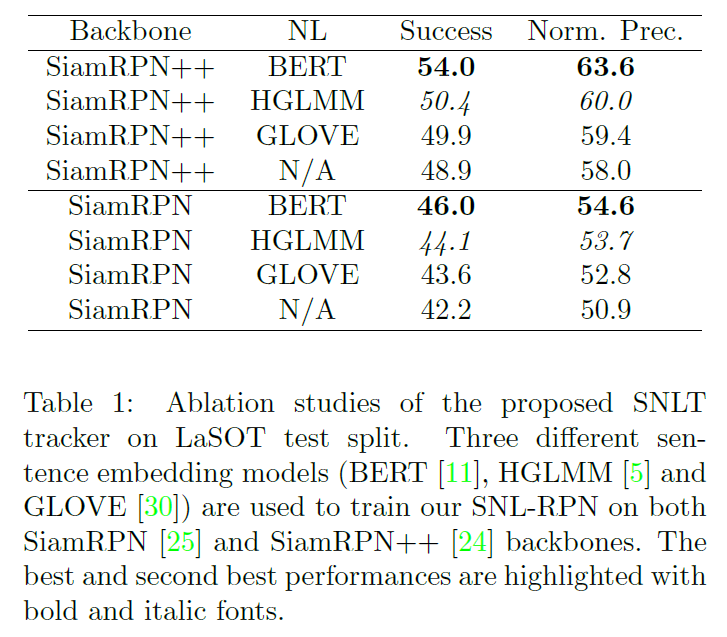

Ablation Studies

表1对比了不同语言模型的效果

图6的两个例子,第一个展示了语言描述可以辅助跟踪器避免模型漂移,而第二个例子语言描述不能唯一地描述目标,导致跟踪器漂移。

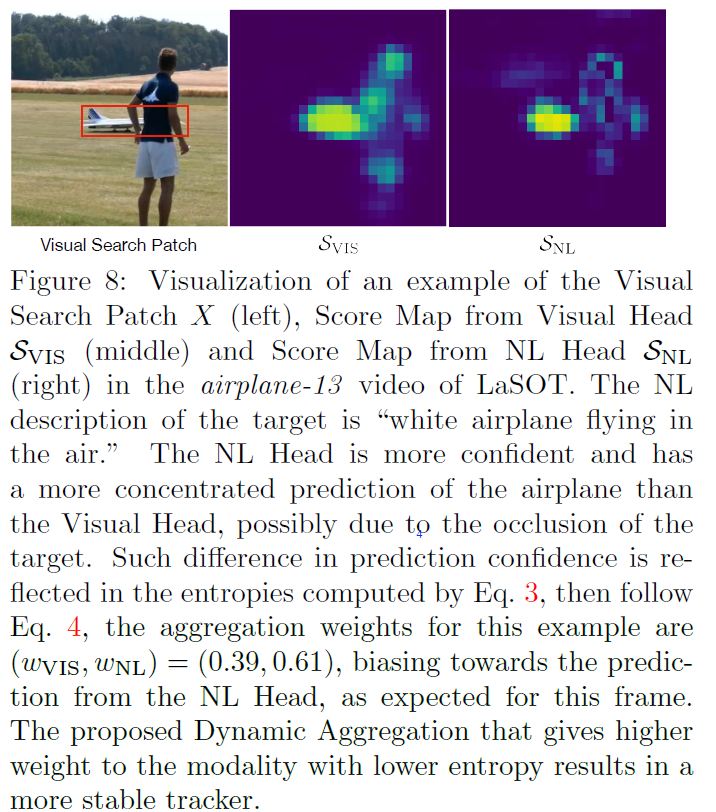

图8展示了视觉和语言的分类响应图,NL head的响应更加准确,可能是由于遮挡阻碍了视觉模型。通过计算响应图的熵,赋予熵更小的NL响应图更大的权重。