HiFT: Hierarchical Feature Transformer for Aerial Tracking

Motivation

现有的孪生跟踪算法大多是基于相似得分图对目标对象进行分类和回归,使用单一的相似图会降低复杂场景下的定位精度,而像SiamRPN++那样单独使用多个相似图分别进行预测又会引入较大计算负担,不适用于移动设备。因此,本文提出一种 hierarchical feature transformer (HiFT) 对多个层级的相似图进行融合,既可以捕获全局的依赖关系,又可以高效地学习多层级特征之间的依赖关系。

在介绍本文方法前,我们先分析经典的transformer架构应用于目标跟踪任务中的难点。

- 预定义的(或学习的)解码query在面对任意跟踪对象时很难保持有效性;

- transformer难以处理小目标(参考deform DETR)。

Method

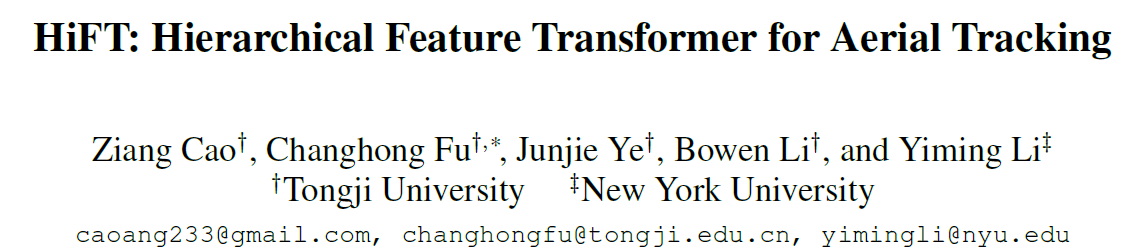

图2为整体框架,分成特征提取,transformer和预测头三部分。特征提取采用高效的alexnet,最后三层特征输入到transformer中,预测头采用类似FCOS的三分支预测(分类、回归、定位质量)。下面详细介绍本文提出的Hierarchical Transformer。

Hierarchical Feature Transformer

HiFT包含高分辨率特征编码和低分辨率特征解码,前者学习不同特征层和空间信息之间的相互依赖关系,以提高对不同尺度(特别是低分辨率)目标的关注;而后者聚合了来自低分辨率深层特征的语义信息。这种全局上下文和层次特征之间的相互依赖大大提升了对复杂跟踪场景的适应能力。

transform的输入是三层不同尺度的互相关相似图,如公式1所示。图3中的$M_3’$ 和 $M_4’$ 则是加上了位置编码。

Feature Encoding

首先对$M_3’$ 和 $M_4’$ 进行相加和归一化的融合,得到$M_E^1 = Norm(M_3’+M_4’)$;然后经过multi-head attention得到 $M_E^2 \in WH \times C$,attention矩阵中同时包含了$M_3’$ 和 $M_4’$的多尺度信息,注意这里MHA中Q, K, V的输入差异;

此外还额外增加了一个调制层 (modulation layer),探索$M_4’$ 和 $M_E^3$ 之间的空间信息。

Feature Decoding

decoder部分和标准的transformer类似,差别在于输入的查询向量不是预定义的query,而是低分辨率的特征$M_5 \in WH \times C$,并且无需位置编码。

作者在实验中堆叠了一个编码和两个解码结构。

Experiments

Evaluation on Aerial Benchmarks

本文的应用环境是无人机跟踪,所以测试数据集均在无人机数据集测试。

Ablation Study

图5中OT表示标准transformer结构,FT表示用特征取代解码器中的object query,PE表示在解码输入中加入位置编码,RL表示在GT的矩形框内采样正样本(本文用的椭圆采样策略)。可以看到,OT使得性能下降,证明预定义的object query不适用于目标任意的跟踪任务;增加了PE后相比不用PE性能大幅下降;使用RL性能同样大幅下降,这样看上去似乎label assign策略的影响都要大于HFT了。

图5展示了本文方法在快速运动、低分辨率和遮挡等场景均可以更聚焦目标。

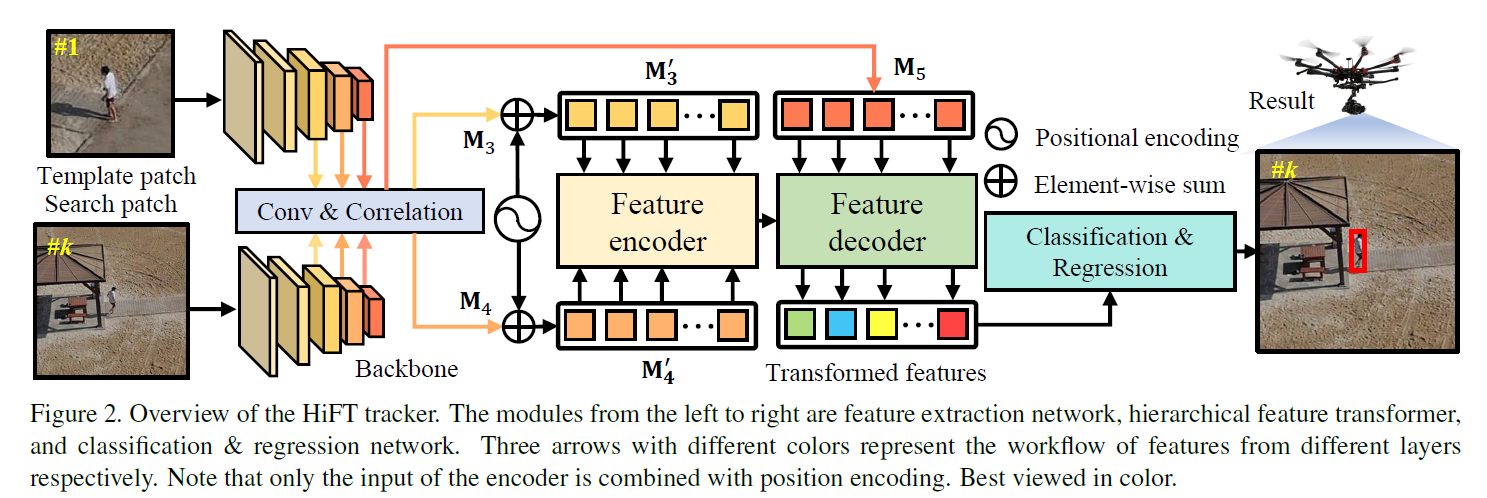

速度一骑绝尘,大于100FPS,并且使用alexnet的性能超过了很多resnet50的算法。并且作者在嵌入式平台NVIDIA AGX Xavier中实验也达到了31.2FPS(未使用tensorrt),非常适合应用。